آدابوست مخفف بوستینگ تطبیقی بوده و یک الگوریتم یادگیری ماشین است که توسط یاو فروند و رابرت شاپیر ابداع شد.[۱] در واقع آدابوست یک متا الگوریتم است که بمظور ارتقاء عملکرد، و رفع مشکل ردههای نامتوزان[۲] همراه دیگر الگوریتمهای یادگیری استفاده میشود. در این الگوریتم، طبقه بند هر مرحله جدید به نفع نمونههای غلط طبقهبندی شده در مراحل قبل تنظیم میگردد. آدابوست نسبت به دادههای نویزی و پرت حساس است؛ ولی نسبت به مشکل بیش برازش از بیشتر الگوریتمهای یادگیری برتری دارد. طبقه بند پایه که در اینجا استفاده میشود فقط کافیست از طبقه بند نصادفی(۵۰٪) بهتر باشد و به این ترتیب بهبود عملکرد الگوریتم با تکرارهای بیشتر بهبود مییابد. حتی طبقه بندهای با خطای بالاتر از تصادفی با گرفتن ضریب منفی عملکرد کلی را بهبود میبخشند. در الگوریتم آدابوست در هر دور

محتویات

- ۱الگوریتم طبقهبندی دوگانه

- ۲درک آماری تقویت کردن

- ۳مطالب مرتبط

- ۴منابع

- ۵پیادهسازیها

- ۶پیوند به بیرون

الگوریتم طبقهبندی دوگانه

داده شدهها:

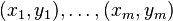

- مجموعه یادگیری:

که

- تعداد تکرارها:

مقداردهی اولیه:

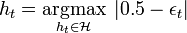

- برای خانواده طبقه بندهای ضعیف ℋ طبقه بند

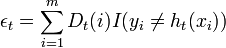

را پیدا کن که قدر مطلق اختلاف نرخ خطای وزن دهی شده متناظر

از ۰٫۵ نسبت به توزیع

حداکثر شود:

- اگر

که

یک آستانه تعین شده قبلی است، توقف انجام شود.

- معمولا مفدار

برای

در نظر گرفته میشود.

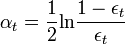

- بروز رسانی:

- که

یک عامل نرمالیزاسیون با مقدار

است که موجب میشود

یک توزیع احتمالاتی مجاز را نشان دهد (مجموع روی همه xها یک شود)

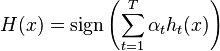

- خروجی نهایی طبقه بند

- توجه شود که معادله بروز رسانی توزیع

بگونهای بروز میشود که

بنابراین بعد از انتخاب بهینه طبقه بند

درک آماری تقویت کردن]

عمل تقویت کردن را میتوان بصورت حداقل کردن یک تابع هزینه محدب روی یک مجموعه محدب از توابع درنظر گرفت.[۳] بطور خاص تابعی که حداقل میشود نمایی است:

و ما بدنبال تابعی به شکل زیر هستیم:

منابع

- پرش به بالا↑ Yoav Freund, Robert E. Schapire. “A Decision-Theoretic Generalization of on-Line Learning and an Application to Boosting”, 1995

- پرش به بالا↑ مهسا المعی نژاد. «روشهای Bagging و Boosting به منظور رفع مشکل کلاسهای نامتوازن». گروه داده کاوی ایران. بازبینیشده در ۲۶ فبریه ۲۰۱۴.

- پرش به بالا↑ T. Zhang, “Statistical behavior and consistency of classification methods based on convex risk minimization”, Annals of Statistics 32 (1), pp. 56-85, 2004.

[thrive_leads id='1265']

که

که

را پیدا کن که قدر مطلق اختلاف نرخ خطای وزن دهی شده متناظر

را پیدا کن که قدر مطلق اختلاف نرخ خطای وزن دهی شده متناظر  از ۰٫۵ نسبت به توزیع

از ۰٫۵ نسبت به توزیع  که

که  یک آستانه تعین شده قبلی است، توقف انجام شود.

یک آستانه تعین شده قبلی است، توقف انجام شود. برای

برای  در نظر گرفته میشود.

در نظر گرفته میشود.

یک عامل نرمالیزاسیون با مقدار

یک عامل نرمالیزاسیون با مقدار  است که موجب میشود

است که موجب میشود  یک توزیع احتمالاتی مجاز را نشان دهد (مجموع روی همه xها یک شود)

یک توزیع احتمالاتی مجاز را نشان دهد (مجموع روی همه xها یک شود)